逻辑回归模型类型解析

逻辑回归有哪些模型

主要的逻辑回归模型如下:

1 线性逻辑回归模型是最基本的逻辑回归模型。

在线性逻辑回归模型中,预测值是对数赔率的线性组合。

它基于这样的假设:样本标签是根据预测值和样本函数的线性组合生成的。

该模型适合处理线性可分离的数据集。

对于非线性可分离数据集,可能需要更复杂的模型。

例如,广义线性模型是一种扩展的线性逻辑回归模型,可以处理更广泛的非线性问题。

2 逻辑回归的另一种模型是多项式逻辑回归。

当存在多个类别标签时,可以使用多项逻辑回归模型。

它将数据集分为几类,并使用逻辑回归为每个类别训练一个单独的模型。

该方法适用于多分类问题。

对于二元分类问题,您可以使用二元逻辑回归模型,它是多项式逻辑回归的特例。

除了二元逻辑回归之外,还有一对一模型也可以解决类似的问题。

它们是针对不同情况的不同解决方案。

每种模式都有其独特的适用场景和特点。

同时,除了上述之外,还有可以处理逻辑回归问题的感知器模型和决策树。

这些模型是机器学习的重要组成部分,在解决各种实际问题中发挥着重要作用。

这些模型的训练过程基于优化算法,通过不断调整模型的参数来优化模型的性能。

同时,这些模型也各有优缺点和当前场景,需要选择合适的模型来解决具体问题。

这些模型的优化算法包括但不限于梯度下降法、牛顿法等。

选择合适的模型后,还必须对模型的性能进行评估和优化,以确保其预测精度满足需求。

同时,可以利用交叉验证等评估方法来可靠地评估模型的性能。

建模并优化缺陷。

结果达到预期目标,满足需求。

在实际应用中,我们不断调试和优化,直到找到最合适的模型,做出更准确的决策,提高整体效率和效果。

逻辑回归模型的训练过程是通过优化算法实现的。

在训练过程中,模型不断调整参数以优化性能。

常用的优化算法包括梯度下降法和牛顿法。

这些算法通过计算损失函数的梯度或二阶导数来更新模型的参数,以最小化预测误差或损失函数值。

梯度下降法适用于大数据集、大量参数的情况,具有收敛速度快、易于实现等优点。

牛顿法虽然迭代次数较少,但计算复杂度较高,对初值选择和矩阵运算的要求较严格。

使用逻辑回归时,需要根据具体问题选择正确的模型和算法,以达到最佳结果。

在实际决策过程中不断调试和优化模型以适应不同的场景和需求非常重要。

3.除了选择合适的模型和算法之外,还必须评估模型的性能进行优化,保证预测精度满足需求。

常用的评估方法包括精确率、召回率、F1分数和交叉验证。

这些方法可以帮助我们了解模型的性能,并根据评估结果优化和调整模型的参数配置,以提高模型的预测精度。

在实际应用中,我们还必须考虑模型的稳定性和可解释性,以便更好地理解和使用模型进行决策 4. 非线性可分离数据集可以通过引入非线性函数或使用核等技术来处理方法。

决策树和随机森林等集成学习方法也可以用来解决逻辑回归问题。

这些方法通过将数据集划分为多个子空间或子树并对每个子空间或子树应用逻辑回归模型来提高模型的概括性和预测准确性。

这些方法都有各自的特点和适用的场景,提高决策效率和准确性的问题。

综上所述,逻辑回归模型包括线性逻辑回归、多项式逻辑回归等不同模型,根据不同场景和问题适用不同的逻辑回归模型。

针对具体需求,情景选择和优化,提高预测精度和决策效率 通过不断调试和优化,找到最合适的解决方案,做出更准确的决策,提高整体效率 了解不同模型的特点和适用场景,选择合适的模型和算法,不断优化和调整参数,是提高预测精度和决策效率的关键因素之一。

逻辑回归有哪些模型

我有以下模型。

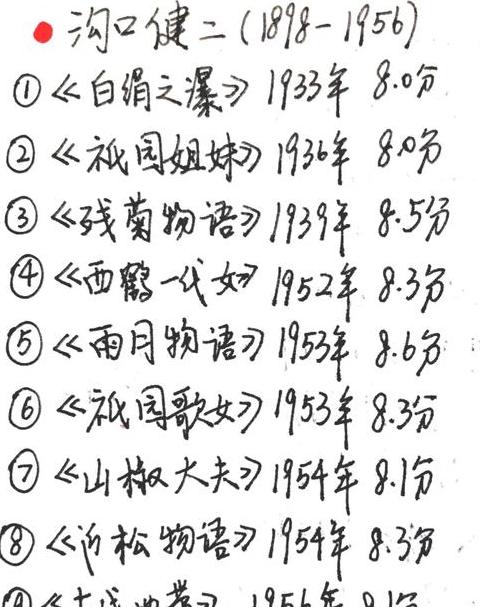

1.二元Logistic回归:

因变量是有两个结果的二分变量,例如win = 1,win = 0。

; 变量可以是分类变量或连续变量。

正样本大小 n 必须至少是自变量数量的 10 倍。

2.无序多类逻辑回归:

因变量是获取健康知识的方式(传统大众媒体=1、互联网等)。

= 2,社区公共关系 = 3);自变量可以是分类变量或连续变量。

它还可用于因变量是有序多类别变量但不符合并行测试条件的数据材料。

。

原理:用因变量各水平(不含参考水平)与参考水平之比的自然对数建立模型方程。

3.有序多类逻辑回归:

因变量是疾病严重程度(轻度=1,中度=2,严重度=3);可以是分类的或连续的。

原理:将多个类别的因变量依次拆分为多个二元逻辑回归。

也就是说,我们需要检验自变量的系数是否相等。

,不需要多重逻辑回归。